Младенческая смертность

Синдром внезапной детской смерти.

По мнению исследователей, шесть из каждых десяти случаев внезапной смерти детей обусловлены небрежностью родителей или несоблюдением элементарных правил ухода за младенцем. Кроме того, ученые пришли к выводу, что значимыми факторами повышенного риска внезапной смерти ребенка являются случаи мертворождения при предыдущих беременностях у матери, социальное неблагополучие семьи, мужской пол младенца. Чаще всего так называемая «смерть в колыбели» происходит на 13 неделе жизни ребенка.

Вопреки расхожим представлениям, в ходе исследования не обнаружено связи синдрома внезапной детской смерти с профилактическими прививками, возрастом матери, авиаперелетами ребенка или типом матраса в его кроватке.

Результаты изучения проблемы требуют как совершенствования системы контроля за случаями внезапной детской смерти со стороны органов здравоохранения, так и разработки широкой образовательной программы для родителей, считают ученые. Рекомендации исследователей по профилактике «смерти в колыбели» оформлены в виде буклета, который будет распространяться среди семей, где недавно появился ребенок.

Трудно найти более страшную ситуацию, чем смерть маленького ребенка, наступившая совершенно внезапно, во сне — без предшествующих болезней, тяжелых травм и вообще без видимых причин. Глубина психического шока у родителей в этом случае порой превышает таковую при неожиданной гибели детей в автомобильных авариях, во время природных катаклизмов и прочих «бытовых» несчастных случаях. Внезапная детская смерть практически всегда ставит разум взрослого человека перед серьезным испытанием на стойкость: неслучайно именно эту ситуацию использовал Стивен Кинг для сюжета «Кладбища домашних животных» — одного из самых, пожалуй, эффектных произведений признанного мастера психотриллера.

В медицинской литературе можно встретить несколько вариантов названий этого загадочного явления: синдром внезапной смерти младенцев, синдром внезапной смерти у детей, синдром внезапной детской смерти (СВДС). Все эти похожие между собой термины в принципе подразумевают одно и то же — внезапную смерть ребенка первого года жизни, объяснить которую не помогают ни подробное изучение медицинской истории малыша, ни результаты патологоанатомического исследования. Чаще всего СВДС происходит во сне, поэтому его еще называют «смертью в колыбели».

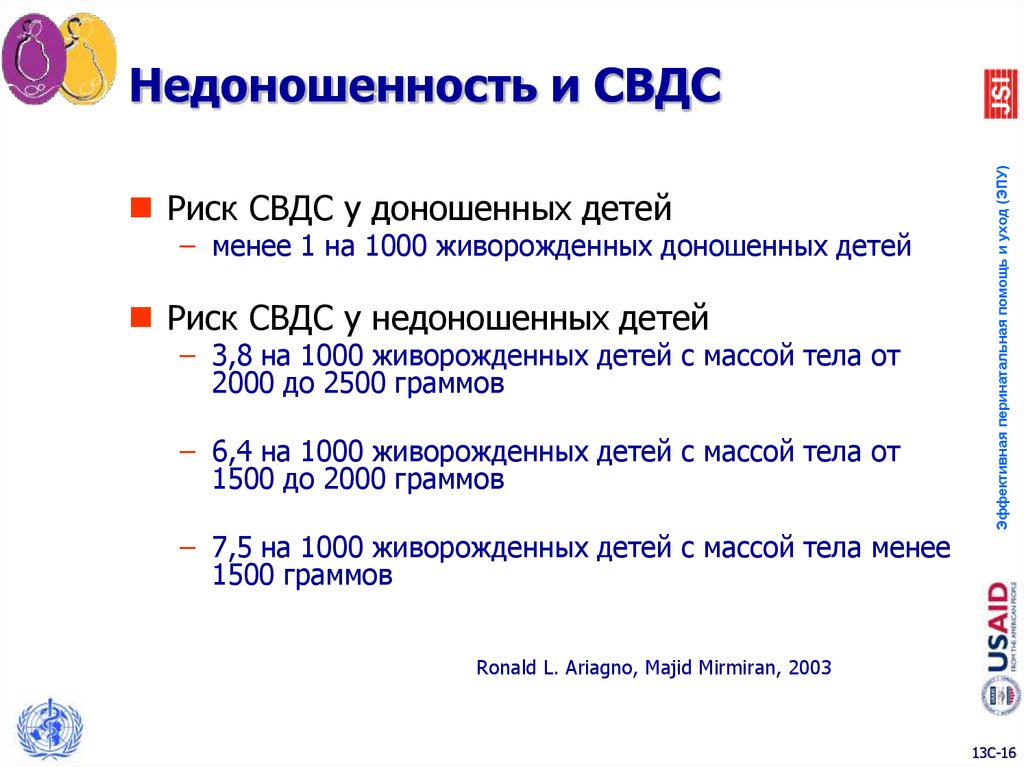

Статистика свидетельствует, что СВДС является причиной гибели примерно пяти-шести детей первого года жизни из каждой тысячи сверстников. Несмотря на то, что довольно интенсивные исследования случаев неожиданной смерти младенцев не привели к объяснению причин этого явления, в ходе изучения проблемы было обнаружено немало «черт характера», свойственных этой патологии.

По данным Национального института здоровья и развития детей (США), период между первым и четвертым месяцем жизни представляет наибольшую опасность в плане внезапной гибели младенца. Обнаружено также, что самый большой «урожай» СВДС собирает в наиболее холодное время года — с октября по март. Дети из индейских и афро-американских семей подвержены риску неожиданной смерти вдвое, а то и втрое чаще, чем их белокожие сверстники. Девочки умирают от СВДС несколько реже мальчиков.

Специалисты полагают, что определенную степень риска внезапной гибели в пору младенчества закладывает для ребенка не кто иной как… его мать, причем еще в период беременности. Дело в том, что изучение большого количества случаев неожиданной детской смерти позволило выявить значимую связь между этим явлением и некоторыми, скажем так, особенностями поведения беременной матери.

Британские педиатры склонны рассматривать небрежность и невнимательность родителей в качестве одной из основных причин СВДС. По их мнению, шесть из десяти случаев внезапной детской смерти происходят именно в результате незнания или нежелания мамы с папой выполнять элементарные правила ухода за грудным ребенком. В пользу этой теории говорит и тот факт, что практически половина случаев СВДС происходит в выходные и праздничные дни, когда родители склонны отдохнуть от забот и вообще всячески развлечься.

В качестве еще одного весьма серьезного фактора риска наступления «смерти в колыбели» ученые склонны рассматривать положение тела малыша во сне. Самой опасной позой считается сон на животе. Существующие на этот счет многочисленные теории не могут в полной мере объяснить причин данной опасности. Однако, по мнению специалистов, наличие связи между сном на животе и случаями внезапной гибели младенцев не вызывает сомнений.

Еще в 1992 году Американская академия педиатрии в качестве одной из важнейших мер профилактики СВДС рекомендовала избегать укладывать детей первого года жизни на живот во время сна. На основании этой рекомендации в США с 1994 года была развернута национальная кампания «Back to Sleep», призванная убедить родителей в том, что их малыши должны спать на спине, на боку, но не на животе. Желаемого эффекта удалось достичь не сразу — уж очень стойкими оказались привычки и семейные традиции. Однако за 4 года широкомасштабной просветительской кампании количество маленьких американцев, спящих на животах, уменьшилось практически вдвое, а количество случаев «смерти в колыбели» сократилось втрое.

Рекомендации Американской академии педиатрии в отношении возможных путей профилактики СВДС не ограничились, конечно же, только положением ребенка во сне. Думается, что и нам, российским родителям, вовсе не помешает ознакомиться подробнее с этими рекомендациями.

Итак, для того, чтобы максимально снизить риск возникновения СВДС, мать должна самым внимательным образом отнестись к себе и своему ребенку еще во время беременности. Курение, наркотики, чрезмерное употребление алкоголя беременной матерью втрое повышают шансы внезапной гибели ребенка на первом году жизни. Кроме того, для профилактики СВДС очень важно регулярное наблюдение врача в период беременности.

Во время сна малыш не должен быть слишком тепло одет. В комнате, где он спит, температура воздуха должна быть комфортной для взрослого человека, одетого в рубашку с коротким рукавом. Ребенок во время сна должен быть укрыт легким одеялом до уровня плеч.

В присутствии грудного ребенка нельзя курить. Более того, если по какой-то причине малыш спит рядом с отцом или матерью, то последние не должны источать резких запахов табака, алкоголя, парфюмерии и т.д.

Материнское молоко — хорошая защита от СВДС, как, впрочем, и от многих других проблем. Поэтому продолжать естественное вскармливание нужно как можно дольше. Вопреки расхожим заблуждениям, вакцинация ни в коей мере не является причиной СВДС и даже наоборот, защищает младенца от множества серьезных проблем. При отсутствии медицинских противопоказаний ребенок должен быть привит.

И последнее. Все, что касается вашего малыша, — очень индивидуально и неповторимо. Поэтому не стесняйтесь задавать интересующие вас вопросы педиатру.

СВДС: что это и как можно снизить риск? | Игорь Новокриницкий

Синдром внезапной детской смерти — неожиданная смерть грудничка в первый год его жизни. Чаще всего у него останавливается дыхание во сне.

Факты о СВДС:

- установить точную причину смерти практически невозможно — ребенок всегда внешне абсолютно здоров;

- наиболее высок риск внезапной детской смерти в первые полгода малыша. После он снижается;

- у мальчиков риск появления синдрома выше, чем у девочек;

- недоношенность, осложнения во время беременности и родов повышают риск появления синдрома.

Полезные советы для снижения появления СВДС.

- укладывайте грудничка спать на спину, пока он сам не научится переворачиваться на бок. Сон на животе в первые месяцы лучше исключить совсем, т.к. в этой позе ребенок легко может уткнуться в матрас и задохнуться;

- уберите лишние вещи из детской кроватки. В ней должен лежать только твердый матрас с натуральным наполнителем. Мягкие бортики замените на те, что надеваются на каждый прут кроватки, или их можно совсем не использовать. Отличная альтернатива одеялу — спальный мешок или теплый комбинезон для сна. А подушку не рекомендуется использовать лет до 2-3;

- при наличии курящего члена семьи лучше не укладывать его рядом с детской кроваткой, так как запах табачного дыма увеличивает риск появления синдрома;

- хорошо проветривайте комнату перед сном, чтобы избежать скопления углекислого газа в помещении. Также организуйте правильную погоду в доме — температуру около 18-22 градусов, влажность 50-60%;

- не увлекайтесь автокреслом как спальным местом. Если малыш спит в нем больше часа, постоянно проверяйте его. Но лучше дольше двух часов не держать ребенка в любом детском девайсе, кроме кроватки;

- не старайтесь сразу переселить грудничка в отдельную комнату.

Безопаснее, когда он спит в одной спальне с родителями. Но если же все-таки решились, то приобретите видеоняню для контроля. Еще можно использовать устройство, которое следит за дыханием малыша и при его длительной задержки подает сигнал.

Безопаснее, когда он спит в одной спальне с родителями. Но если же все-таки решились, то приобретите видеоняню для контроля. Еще можно использовать устройство, которое следит за дыханием малыша и при его длительной задержки подает сигнал.

Поделитесь, каким советом обязательно воспользуетесь.

Профилактика синдрома внезапной смерти младенцев

Синдром внезапной детской смерти ( СВДС )— один из самых распространенных кошмаров современных родителей. Согласно названию, СВДС — это внезапная и необъяснимая смерть от остановки дыхания внешне здорового младенца во сне. Случаи внезапной смерти младенцев (СВСМ) известны с давних времен, но объяснения им не найдено до настоящего времени, несмотря на то, что над этой проблемой работают ученые всего мира. Но есть целый ряд рекомендаций, которые помогут сделать сон вашего ребенка максимально безопасным.

Подвержены внезапной смерти как недоношенные так и доношенные дети. Неожиданно, без какой-либо видимой причины у ребенка происходит остановка дыхания – апноэ.

В период внутриутробного развития ребенок «дышит» через плаценту матери. Появившись на свет, он и не подозревает об опасностях, которые могут его подстерегать в уютной детской кроватке: удушье из-за срыгивания пищи, попадании в трахею инородных предметов, перебоях дыхания из-за неустойчивости нервной и дыхательной функций.

Дети грудного возраста подвержены нерегулярности дыхания. Даже у совсем здоровых детей наблюдаются короткие паузы в дыхании, но их продолжительность не должна быть больше 12-15 секунд. Частые задержки дыхания (апноэ) приводят к кислородному голоданию головного мозга, что впоследствии может отразиться на умственном развитии ребенка. Усугубить ситуацию может ослабленность малыша по причине недоношенности, проблемы с перевариванием пищи, особенно при искусственном вскармливании, а также инфекции, значительно увеличивающие риск остановки дыхания.

К группе риска по развитию

СВСМ относятся дети:· рожденные путем кесарева сечения, с осложнениями в родах,

· появившиеся на свет с весом менее 2 кг, недоношенные

· находящиеся на искусственном вскармливании;

· чьи сестры и братья погибли от СВСМ.

· рожденные от матери до 20 лет, когда она при этом одиночка или не состояла на учете у врача, при болезни у матери во время беременности, небольшом разрыве между беременностями (менее года).

Следует помнить, что к факторам риска относятся :

· употребление алкоголя матерью,

· курение в квартире, а тем более в комнате, где находится малыш, особенно курение матери,

Рекомендации по мерам профилактики СВСМ:

· ночной сон ребенка на спине (положение спящего ребенка на животе с повернутой на бок головкой вызывает сдавливание артерии позвоночника, что становится причиной гипоксии и апноэ),

· сон в своей кроватке в комнате родителей, кровать родителей — небезопасное место для него: он может задохнуться, если застрянет между подушками или в пространстве между матрасом и стеной. Еще один возможный сценарий — родитель придавит младенца во сне.

· кормление ребенка грудью, если это возможно. Грудное вскармливание снижает риск СВДС. После ночного кормления обязательно положите его обратно в кроватку.

· если перед сном было кормление, надо обязательно дождаться, чтобы малыш срыгнул.

· проветривание детской комнаты перед сном, температура в комнате должна быть 22-24 градуса,если вы беспокоитесь о том, что ребенку может быть холодно, используйте комбинезон или конверт, но не одеяло,

· жесткий матрас и отсутствие подушки в детской кроватке, минимум бортиков для улучшения циркуляции воздуха),отсутствие в кроватке посторонних предметов ( игрушек, пеленок, пакетов и т. п.).так как любой из этих предметов может накрыть рот и нос малыша и ограничить ему доступ кислорода, одновременно способствуя вдыханию скопившегося в этом пространстве углекислого газа.

п.).так как любой из этих предметов может накрыть рот и нос малыша и ограничить ему доступ кислорода, одновременно способствуя вдыханию скопившегося в этом пространстве углекислого газа.

· избегайте чрезмерного укутывания малыша и тугого пеленания, чтобы не затруднять дыхание,

· Не рекомендуется надолго оставлять спящего младенца в прогулочной коляске, креслице, автокресле, переноске, на диване или кушетке. Заснувшего ребенка следует по возможности скорее переложить в кровать.

Внезапную остановку дыхания и сердцебиения младенцев необходимо вовремя предотвратить.

Следует помнить:

· чаще всего дети погибают от СВСМ ночью и в утренние часы,

· в возрасте от 2 до 6 месяцев.

· СВСМ чаще встречается у мальчиков, чем у девочек.

· ученые заметили, что СВСМ дети подвержены в холодное время года (осенью и зимой) когда идет подъем простудных заболеваний и снижен иммунитет.

Что необходимо сделать, если ваш ребенок не дышит?

Проверьте частоту дыхания, приблизившись ко рту и носу ребенка, стараясь уловить движение грудной клетки.

Оцените цвет кожи. Об остановке дыхания свидетельствует бледность кожных покровов и посинение губ.

Если родители успевают заметить остановку дыхания крохи во сне, ситуацию можно исправить. В первую очередь, следует стимулировать дыхательный центр. Надо взять ребенка на руки и растормошить его — бояться разбудить его в такой ситуации не стоит, здесь главное спасти ему жизнь. После того как дыхание появилось, стоит аккуратно помассировать ручки, ножки, ступни и мочки ушей. Также советуют энергично провести пальцем вдоль позвоночника.

Если кроха не проснулся, а дыхание не восстанавливается, необходимо срочно вызывать бригаду скорой помощи.помощь.

Все эти меры могут помочь, только если будут оказаны своевременно. Самое главное – вовремя заметить надвигающуюся опасность и активными действиями прервать развитие апноэ.

Самое главное – вовремя заметить надвигающуюся опасность и активными действиями прервать развитие апноэ.

Чем больше любви и внимания вы подарите своему малышу, тем больше поводов для радости и удивительных моментов в жизни получите взамен.

Апноэ и СВДС (SIDS)

Монитор дыхания SNUZA вовремя диагностирует остановку дыхания и призывает принять необходимые действия для восстановления дыхания малыша.

Мобильный монитор дыхания Snuza Hero имеет автоматичекую функцию вибрации и самостоятельно восстанавливает дыхание ребенка в случае апноэ!

Уважаемые родители! Если ваш малыш входит в группу риска возникновения АПНОЭ, пожалуйста ознакомьтесь с видеоматериалом по оказанию первой помощи младенцу.

Что такое СВДС и что такое АПНОЭ?

Остановка дыхания называется АПНОЭ, об СВДС — далее.

Состояние, сопровождающееся отсутствием дыхательных движений более 20 секунд; характеризуется бледностью кожных покровов, снижением тонуса мышц, вялостью, цианозом и брадикардией (пониженной частотой сердцебиения), иногда шоком и рвотой, требует экстренных реанимационных мероприятий в связи с возможным смертельным исходом. Частый симптом при различной патологии новорожденных, но не самостоятельное заболевание.

Типы апноэ и причины их развития

1. Центральное апноэ — невозможность сокращений мышц грудной клетки и живота, вызванная отсутствием импульсов из ЦНС; индуцируется несколькими факторами (может также быть идиопатическим и встречаться у детей, в семьях которых имелись случаи СВДС).

К причинам развития центрального апноэ относят:

- Недоношенность

- Лекарственные препараты, назначенные матери или ребенку

- Бактериальные или вирусные инфекции

- Анемия (малокровие, группа заболеваний, характеризующихся снижением содержания в эритроцитах гемоглобина)

- Нарушения сердечного ритма (в особенности синдром Вольфа-Паркинсона-Уайта)

- Эпилепсия

- Гастроэзофагеальный рефлюкс (заброс содержимого желудка через нижний пищеводный сфинктер в пищевод) или аспирация (засасывание желудочного содержимого в дыхательные пути, опосредованная активностью блуждающего нерва)

- Гипогликемия (снижение уровня сахара в крови)

- Гиповентиляция альвеол центрального происхождения (возникает в тех случаях, когда вентиляционный обмен газов при вдох-выдохе оказывается недостаточным)

- Бронхолёгочная дисплазия (заболевание легких, развивающееся преимущественно у недоношенных детей в периоде новорожденности)

- Внутричерепная и спинальная травма

- Сепсис (инфекционное заболевание, вызываемое попаданием в кровь и ткани гноеродных микроорганизмов и продуктов их жизнедеятельности — токсинов)

- Электролитные расстройства

- Гипербилирубинемия (увеличение количества билирубина в сыворотке крови)

2. Обструктивное апноэ. Если к развитию апноэ приводит обструкция (непроходимость) дыхательных путей и если нет поступления воздуха через нос или рот, могут отмечаться движения мышц грудной клетки и живота.

Обструктивное апноэ. Если к развитию апноэ приводит обструкция (непроходимость) дыхательных путей и если нет поступления воздуха через нос или рот, могут отмечаться движения мышц грудной клетки и живота.

К причинам развития обструктивного апноэ относят:

- Макроглоссия (аномально большой язык, например, при синдромах Дауна, Пьера Робена, при гипотиреоидизме)

- Увеличение миндалин

- Нескоординированная работа задней гортанной мышцы (например, при параличе или травме)

- Ларингоспазм (внезапное непроизвольное сокращение мускулатуры гортани

- Заячья губа

- Ахондроплазия (врождённая болезнь)

- Смешанное апноэ — сочетание двух видов апноэ. Первоначально отмечают центральное апноэ, вслед за которым развивается обструкция дыхательных путей. (подробнее http://www.komkon.org/~napoleon/PULMO/b-apnoe.htm)

Что такое СВДС (SIDS)?

Синдром внезапной детской смерти (СВДС; СВСР; SIDS) — случаи внезапной и неожиданной смерти новорожденных и младенцев; при патологоанатомическом исследовании причина смертельного исхода не устанавливается; является главной причиной смерти у детей первого года жизни.

Из Векипедии: «Синдро́м внеза́пной де́тской сме́рти (СВДС, лат. Mors subita infantum, англ. sudden infant death syndrome (SIDS) — внезапная смерть от остановки дыхания внешне здорового младенца или ребенка, при которой вскрытие не позволяет установить причину летального исхода. Иногда СВДС называют «смертью в колыбели», поскольку ей могут не предшествовать никакие признаки, часто ребенок умирает во сне. Впервые термин СВДС введен в 1969 году. Исследование проблемы ведется с 50-х годов, со второй половины 80-х годов изучение СВДС интенсифицировалось.

Показатель СВДС на 1000 рождённых детей в 1999 году по некоторым странам:

Германия — 0.78

США — 0.77

Россия — 0.43

Швеция — 0. 45

45

Италия — 1 »

Комментарий: Эта статистика только по СВДС от невыясненных после вскрытия причин, при этом остальные погибшие, даже внешне здоровые, причина остановки дыхания которых была установлена после вскрытия, в эту статистику не включены!

По словам врачей в не официальных беседах, в России диагноз СВДС (для улучшения статистики и сохранения собственного «лица») стараются скрыть и пишут обычно — смерть в результате ОРЗ или ОРВИ!

Между тем по словам председателя Американского Института по изучению СВДС (American SIDS Institute http://www.sids.org) Марка Петерзелла (Marc Peterzell):

«до сих пор от внезапной остановки дыхания в США происходит около 2500 детских смертей в год и многие тысячи по всему миру»

Википедия (продолжение):

«Точные причины СВДС пока не установлены. Строго говоря, к СВДС относят любые случаи смерти непонятной этиологии, что заставляет некоторых медиков и исследователей критично относиться к выделению СВДС в отдельное заболевание. Если на секции, куда направляют детей с предварительным диагнозом СВДС, обнаруживаются болезни (врожденные пороки развития, опухоли, тяжелые инфекции — что составляет примерно треть случаев), окончательный диагноз СВДС не ставится. Однако и в случае неясной этиологии, как правило, на секции находят признаки хронической гипоксии.

Последние десятилетия изучаются факторы, коррелирующие с синдромом внезапной детской смерти. Вопрос о взаимодействии факторов пока открыт.

Сопутствующие СВДС факторы:

- Сон на животе (основной фактор риска, вызывающий минимум сомнений. При изменении официальной рекомендации с «укладывать на живот» на «укладывать на спину» в странах Западной Европы с 1992 года смертность сократилась в 2-3 раза, аналогичные результаты получены в США и других странах. Единственная страна Западной Европы, где смертность от СВДС в начале 90-х годов возросла — территория бывшей ГДР, где от советской медицинской традиции перешли к западноевропейской, и матери стали чаще укладывать детей на живот).

- Излишнее укутывание, теплая одежда. Вероятно, по этой причине в ряде стран последние годы педиатры официально рекомендуют использовать ночной мешок (стандартизованной термостойкости) вместо одеяла, хотя другие соображения (скапливание углекислого газа под одеялом и др.) тоже могут иметь значение. Следует отметить, что переохлаждать ребенка в аспекте риска СВДС тоже не рекомендуется.

- Слишком мягкое основание кровати (колыбели). В частности, по неизвестным причинам (возможно, в связи с взаимодействием факторов), высок риск СВДС у детей, спящих на диване. Не рекомендуется использование подушки.

- Уже происходившие опасные симптомы (беспричинная остановка дыхания или сердца) у ребенка или его братьев и сестер.

- Мать-одиночка моложе двадцати лет, которая не обращалась к врачу за дородовой помощью.

- Болезнь матери во время беременности.

- Промежуток между первой и второй беременностью слишком мал (менее 1 года) или если раньше имели место выкидыши.

- Курение матери или употребление спиртных напитков или наркотиков (героина).

- Осложненные роды (при тазовых предлежаниях плода) (риск возрастает в 7 раз).

- Длительные роды (более 16 часов) (риск возрастает в 2 раза).

- Проблемы пренатального развития (значительные потрясения нервной системы в утробе матери). При дородовых стрессах замедляется рост этих детей, малый рост и вес при рождении.

- Недоношенные дети.

- Второй и третий ребенок в семье более подвержены риску, нежели первенец.

- Двойни и особенно тройни.

- Неспособность брать грудь у матери.

- Искусственное вскармливание.

- Мужской пол ребенка (61 % случаев СВДС приходится на мальчиков).

- Возраст ребенка (максимум случаев СВДС относится к возрасту 2-4 месяца).

- Сон в раздельных с родителями комнатах.

- Совместный сон матери и младенца (в одной кровати).

Вопреки широко распространенной в интернете информации, большинство исследований показывают, что совместный сон сопряжен с повышенным риском СВДС. Американская Академия педиатрии рекомендует спать раздельно. Однако следует учитывать, что взаимодействие факторов изучено недостаточно хорошо. Не исключено, что в повышенный риск СВДС от совместного сна вносят свой вклад сопряженные факторы: невнимательность к врачебным рекомендациям и невнимание к ребенку, курение и употребление спиртных напитков родителей (табачный или алкогольный запах больше влияет на ребенка, если родители спят рядом, есть и риск по невнимательности накрыть ребенка,

Вопреки широко распространенной в интернете информации, большинство исследований показывают, что совместный сон сопряжен с повышенным риском СВДС. Американская Академия педиатрии рекомендует спать раздельно. Однако следует учитывать, что взаимодействие факторов изучено недостаточно хорошо. Не исключено, что в повышенный риск СВДС от совместного сна вносят свой вклад сопряженные факторы: невнимательность к врачебным рекомендациям и невнимание к ребенку, курение и употребление спиртных напитков родителей (табачный или алкогольный запах больше влияет на ребенка, если родители спят рядом, есть и риск по невнимательности накрыть ребенка, - Бедность (неспособность купить детскую кровать или нехватка места в комнате). На это указывают и результаты работ по корреляции между совместным сном и невнимательностью родителей к рекомендациям. Характерно, что есть культуры с резко пониженным средним риском СВДС, где принято спать с ребенком в одной кровати (Япония; Гонконг). Однако есть и культуры с резко повышенным средним уровнем СВДС, где также принято спать с детьми. Таким образом, повышенный риск совместного сна не вполне пояснен и нуждается в дальнейшем изучении.

- Предполагают, что СВДС может быть вызван сбоями в функционировании автономной нервной системы, особенно тех её отделов, которые связаны с дыханием и работой сердца, в частности, дефицитом серотонина.

- В 1980-е годы существовала гипотеза, что часть случаев СВДС связана с тем, что недостаточно развитый водитель ритма дыхания, затухая под воздействием неудачного случайного сингулярного стимула, не в состоянии возобновить движение. У взрослых людей система множественных водителей ритма дыхания, кровообращения и др. устроена значительно сложнее и надежнее.

- Скапливание углекислого газа в повышенной концентрации. Конкретные механизмы, останавливающие дыхание, не известны.

- Незрелость дыхательного центра, в сочетании с другими факторами (простуда, переохлаждение, сигаретный дым).

«Следует отметить, что все вышеперечисленные гипотезы являются различными формулировками близких предположений.

Вакцинация не является фактором риска. …»

(Подробнее http://ru.wikipedia.org/wiki/Синдром_внезапной_детской_смерти)

עתיד | СВДС

«Смерть в колыбели», это широко распространённое определение, используемое для описания внезапной и неожиданной смерти младенца, не имеющей никакого объяснения. В медицине используется термин Синдром Внезапной Младенческой Смерти (СВМС). Некоторые случаи внезапной и неожиданной смерти можно объяснить (в случае ДТП, смертельного скоротечного заражения или метаболической смерти). Только случаи, тщательно проверенные и не имеющие объяснения, являются случаями смерти в колыбели.

Медицинское определение: внезапная и неожиданная смерть здорового младенца, оставшаяся необъясненной после всех необходимых посмертных экспертиз: посмертное вскрытие, исследование места происшествия и изучение медицинской истории малыша; внезапная смерть младенца или ребенка, которую невозможно было предвидеть, и при патологоанатомическом исследовании отсутствуют адекватные для объяснения причины смерти.

Виллигер (JAMA 1999) – требует ставить диагноз через отрицание. Нужно отклонить все возможные известные причины, которые могли бы объяснить смерть, и только после этого определить смерть, как «смерть в колыбели».

Частота: смерть в колыбели, является наиболее распространенной причиной смерти среди младенцев в возрасте от одного месяца до года. 99% случаев происходят до 6-имесячного возраста. В Израиле происходит около 60-и случаев внезапной необъясненной смерти младенцев в год. В западном мире 0.7-1 случаев на каждые 1000 успешных родов. Пик частоты смертности падает на возраст от двух до четырех месяцев, смерть обычно происходит ночью во время сна.

Факторы: несмотря на тысячи проведенных исследований, до сих пор не найдены объяснения или причины, с помощью которых можно определить малышей находящихся в опасности. Так как умершие малыши ничем не отличаются от других — ни физиологическим строением, ни иммунной системой, одна из теорий гласит, что, возможно, речь идет об одном или нескольких легких дефектах, которые тяжело распознать, и только в некоторых конкретных случаях или в конкретные периоды в жизни малыша (когда он особенно уязвим), накопившееся влияние этих дефектов приводит к смерти.

Факторы риска:

1. Лежание на животе. С 1998 года существуют инструкции укладывать малыша на спину на время сна (лежание на боку увеличивает опасность смерти в колыбели в два раза по сравнению с лежанием на спине). Несмотря на то, что причины явления еще не найдены, предотвращение фактора лежания на животе, значительно уменьшило процент смертности (до 70%). Несмотря на заметное снижение смертности, смерть в колыбели все еще является основной причиной смерти среди младенцев (в возрасте от месяца до года). В каком положении рекомендуется укладывать малыша спать? Несмотря на то, что причины смерти еще не найдены, исследователям ясно, что смерть вызывается каким-то внешним фактором или сочетанием обстоятельств, усугубляющиеся положением малыша на животе.

В 1992 были опубликованы рекомендации укладывать малышей спать на спине или на боку, так как в эпидемических исследованиях было обнаружено, что около 80% умерших внезапной смертью малышей были найдены лежащими на животе. Поэтому появилось предположение, что положение малыша на животе является одним из факторов риска.

В 1998 году вышло однозначное постановление Американской академии педиатрии, укладывать малышей исключительно на спину. Это произошло после того, как выяснилось, что младенцы, лежащие на боку, подвержены риску в два раза большему, чем те которые лежат на спине. Объясняется это тем, что когда малыш лежит на боку, ему легче перекатиться на живот — а это, как уже известно, более опасное положение.

В анатомическом исследовании, проведенном доктором Шац и её сотрудниками, было найдено, что когда малыш лежит на спине, голова и шея вытянуты в одну линию со спиной, таким образом, его дыхательные пути полностью открыты.

Все аргументы, говорящие о том, что лежать на спине опасно для малыша, были опровергнуты: нет опасности увеличения срыгивания, приплюснутости черепной коробки или дефектного ортопедического развития спины. Итак, ребенка однозначно нужно укладывать на спину!

Почему не стоит укладывать малыша на живот, ведь лежание на спине сопряжено с опасностью удушья вследствие срыгивания? Раньше действительно было принято укладывать малыша на живот из опасения удушья в следствие срыгивания. Сегодня, большое количество исследований в западном мире, особенно в Англии и в Австралии, указывают на то, что лежание на животе во время сна опасно, так как может являться причиной смерти в колыбели. При этом, такое положение во время сна не грозит повышенной заболеваемостью или смертностью связанными с другими факторами, включая вдыхание пищи в легкие. Этот вывод был сделан после того, как более 80% найденных мертвыми малышей, умерших по причине Синдрома Внезапной Смерти, были найдены лежащими на животе. Опасность смерти в колыбели при лежании на животе, как выяснилось, выше в 3-5 раз, чем при лежании на боку или на спине. Ученые, которые обнаружили связь между положением малыша лежа на животе и внезапной смертью, предполагают, что эта поза может привести к механической блокировке дыхания и перекрытию носа и рта — вплоть до удушья. Более того, когда малыш лежит на животе, он выдыхает углекислый газ в простыню, но из-за положения младенца, этот газ не распространяется и малыш снова его вдыхает, а это может быть опасно для его жизни. Дополнительные проблемы, которые могут возникнуть, как следствие положения малыша (на животе): давление на межпозвоночную артерию, а так же перегрев, так как в таком положении тепло распространяется меньше, чем при положении на спине. Итак, укладывать малыша на живот во время сна опасно! В течении дня, когда малыш бодрствует и находится под присмотром взрослого человека, желательно укладывать малыша на живот, для того, чтобы он привыкал к разным позам и мог развивать свои моторные способности.

2. Курение. После отмены положения лежа на животе выяснилось, что основным фактором риска на сегодняшний день является курение. Курение матери в период беременности, а так же курение рядом с малышом после его рождения являются пассивным курением. Можно и должно и предотвратить курение рядом с малышом и таким образом уменьшить опасность смерти в колыбели.

Раскрыт возможный механизм синдрома внезапной детской смерти

Исследователи под руководством специалистов из Университета Вашингтона (Сиэтл) предложили молекулярный механизм, объясняющий причины синдрома внезапной детской смерти — внезапной остановки сердца у младенца без видимых на то причин . Это явление невозможно предотвратить, потому что его причины неясны, хотя на этот счет существует много гипотез. В тексте статьи подчеркивается, что внезапная остановка сердца может настигнуть новорожденного ребенка после того, как он начинает сосать грудное молоко.

Авторы работы проверяли гипотезу, согласно которой к синдрому внезапной детской смерти приводит мутация гена HADHA, которая вызывает дефицит митохондриального трифункционального белка альфа (TFPa), необходимого для бета-окисления жирных кислот (деградация жирных кислот по этому пути — один из основных источников энергии для синтеза АТФ). Это может стать причиной нарушения нормального функционирования кардиомиоцитов.

Чтобы создать модель патологии in vitro, исследователи вырастили кардиомиоциты из индуцированых плюрипотентных стволовых клеток (iPSC) человека, в которые с помощью системы CRISPR/Cas9 внесли мутацию гена HADHA. Для ускоренного созревания кардиомиоцитов использовали оригинальный коктейль на основе микроРНК, который действовал на эпигенетический регулятор созревания HOPX.

Выращенные в эксперименте мутантные кардиомиоциты повели себя неправильно: они не могли утилизовать жирные кислоты, которые добавляли в их среду. При этом у них был изменен транспорт ионов кальция через мембрану, что ведет к нарушению динамики деполяризации и реполяризации мембраны. Мутантные кардиомиоциты сокращались реже, чем обычные, и с переменными интервалами. Такая ситуация в сердечной мышце провоцирует аритмию.

Секвенирование РНК в мутантных и нормальных кардиомиоцитах показало, что в мутантных меняется экспрессия метаболических генов. Такие кардиомиоциты внешне выглядят как зрелые, но биохимически зрелыми не становятся. При потере способности к бета-окислению жирных кислот в клетках нарушается работа митохондрий, в митохондриях снижается протонный градиент мембраны, нарушается созревание кардиолипина — фосфолипида внутренней мембраны, необходимого для функционирования митохондрий, и даже нарушается формирование крист внутренней мембраны, увеличивающих ее поверхность.

Ученые предполагают, что младенцы с мутацией гена HADHA не могут усваивать жирные кислоты из материнского молока, и в их кардиомиоцитах нарушается работа митохондрий по тому же механизму, который был смоделирован in vitro.

Они попробовали исправить митохондриальные нарушения при помощи тетрапептида эламипретида (SS-31) — вещества, которое действует на кардиолипин и предотвращает деполяризацию митохондриальной мембраны. Результаты предварительного эксперимента позволяют предположить, что это правильный путь к восстановлению нормальной работы митохондрий.

Калининградский эксперт рассказал о причинах внезапной детской смерти и мерах предосторожности

По статистике, от синдрома внезапной детской смерти в Калининградской области в год погибают два ребёнка — это соответствует общероссийским показателям. О том, кто находится в группе риска и что делать, если малыш вдруг начал задыхаться, «Клопс» рассказала главный внештатный педиатр министерства здравоохранения Калининградской области Наталья Берездовец.

Группа риска

«Как правило, опасный диагноз проявляет себя следующим образом: в силу невыясненных причин ребёнок перестаёт дышать. Надо понимать, что синдром внезапной детской смерти (СВДС) — это диагноз-исключение. То есть он ставится, когда причины гибели, несмотря на различные экспертизы, установить не удалось», — пояснила Берездовец.

Эксперт уточнила, что СВДС подвержены дети в возрасте до года, а пик трагических случаев приходится на два — четыре месяца. Из всего числа погибших младенцев 60% — мальчики. Чаще это происходит ночью — с полуночи до шести утра, потому СВДС ещё называют смертью в колыбели.

«Я изучала литературу, посвящённую этому вопросу, и пришла к выводу, что одним из факторов, предрасполагающих ребёнка к синдрому, может быть недостаточное количество серотонина — одного из регуляторов дыхания. Исследования гормонального фона погибших показали, что у подавляющего большинства он был ниже нормы», — отметила главный педиатр.

Кроме того, в группе риска дети курящих и пьющих родителей, недоношенные малыши, дети на искусственном вскармливании и рождённые при помощи кесарева сечения.

Сон с родителями, отдельная спальня и другие причины

Чётких причин возникновения СВДС нет, но в девяти случаях из десяти погибшие дети спали в кровати с родителями.

«Уставшая мама засыпает рядом с младенцем в процессе кормления, но малыш может уткнуться ртом и носом в грудь и задохнуться. Поэтому до года ребёнок должен спать в своей кроватке, которая стоит в родительской спальне, чтобы в случае чего папа или мама могли своевременно обратиться за помощью», — подчёркивает Наталья Берездовец.

Эксперт советует внимательно отнестись обустройству спального места. Ребёнок должен отдыхать только на спине, в просторной колыбели, на упругом и не пышном матрасе.

«Всякие мягкие бортики, пышные перинки и одеялки исключаем сразу. Малыш может попытаться перевернуться на живот и задохнуться в них. Даже подушечку следует класть под матрасик, чтобы она создавала лёгкий изгиб и делала место сна более удобным, но не была фактором риска», — отмечает эксперт.

Первая помощь при СВДС

Приступ можно обнаружить по следующим признакам: дыхание у ребёнка становится слабым, мышцы теряют тонус — он начинает синеть и как бы обмякать. Если вовремя принять меры, грудничка можно спасти. Нужно немедленно вызвать скорую помощь.

«До приезда врачей необходимо слегка встряхнуть ребёнка, похлопать его по конечностям и сделать массаж: интенсивно провести вдоль позвоночника пальцами рук, растереть ножки и мочки ушей», — объяснила эксперт.

Трагический случай с восьмимесячной девочкой произошёл 10 октября в одной из квартир на ул. Красной. Около 13:00 женщина, присматривавшая за ребёнком, позвонила в скорую и сообщила, что младенец посинел и перестал дышать. Прибывшие на вызов медики констатировали смерть малышки.

svds (функции MATLAB)

svds (функции MATLAB)| Справочник функций MATLAB |

Несколько особых значений

Синтаксис

s = svds (A) s = svds (A, k) s = svds (A, k, 0) [U, S, V] = svds (A, ...)

Описание

svds (A) вычисляет пять наибольших сингулярных значений и связанных сингулярных векторов матрицы A .

свдс (А, к) вычисляет k наибольших сингулярных значений и связанных сингулярных векторов матрицы A .

свдс (А, к, 0) вычисляет k наименьших сингулярных значений и связанных сингулярных векторов.

С одним выходным аргументом s — вектор сингулярных значений. С тремя выходными аргументами и если A равно m -by- n :

-

Uсоставляетм-by-kс ортонормированными колоннами -

Sпо диагоналиkнаk -

Visn-by-kс ортонормированными столбцами -

U * S * V 'является ближайшим рангомkприближение кA

Алгоритм

svds (A, k) использует eigs , чтобы найти собственные значения k наибольшей величины и соответствующие собственные векторы B = [0 A; А '0] .

svds (A, k, 0) использует eigs , чтобы найти 2k наименьших собственных значений амплитуды и соответствующих собственных векторов B = [0 A; A '0] , а затем выбирает положительные собственные значения k и их собственные векторы.

Пример

west0479 — реальная разреженная матрица размером 479 на 479 пикселей. svd вычисляет все 479 сингулярных значений. svds выделяет наибольшее и наименьшее единичные значения.

нагрузка запад 0479 s = svd (полный (west0479)) sl = svds (west0479,4) ss = svds (west0479,6,0)

На этих графиках показаны некоторые сингулярные значения west0479 , вычисленные с помощью svd и svds .

Наибольшее сингулярное значение west0479 можно вычислить несколькими способами:

и оценка:

См. Также

svd , eigs

| svd | переключатель |

© 1994-2005 The MathWorks, Inc.

Разложение по сингулярным значениям — обзор

2.10 Разложение по сингулярным значениям

Разложение по сингулярным значениям (SVD) матрицы m × n A задается как

(2.23) A = USVT (или A = USVH, если A является комплексным)

, где U — ортогональная матрица m × m, а V — ортогональная матрица n × n. Если A является комплексным, то U и V являются унитарными матрицами. Во всех случаях S — это вещественная диагональная матрица m × n. Элементы главной диагонали этой матрицы называются сингулярными числами A . Обычно они располагаются по убыванию так, чтобы s1> s2> …> sn. Таким образом,

S = [s10… 00s2… 0 00… sn00… 0 ⋮⋮⋮ 00… 0]

Сингулярные значения являются неотрицательными квадратными корнями из собственных значений ATA.Поскольку ATA является симметричным или эрмитовым, эти собственные значения действительны и неотрицательны, так что особые значения также являются действительными и неотрицательными. Алгоритмы вычисления SVD матрицы даны Голубом и Ван Лоаном (1989).

SVD матрицы имеет несколько важных приложений. В разделе 2.4 мы ввели упрощенную форму иерархии строк матрицы и объяснили, как функция Matlab rref дает информацию, из которой можно вывести ранг матрицы. Однако ранг может быть более эффективно определен из SVD матрицы, поскольку ее ранг равен количеству ее ненулевых сингулярных значений.Таким образом, для матрицы 5 × 5 ранга 3 s4 и s5 будут равны нулю. На практике вместо подсчета ненулевых сингулярных значений Matlab определяет ранг на основе SVD путем подсчета количества сингулярных значений, превышающих некоторое значение допуска. Это более реалистичный подход к определению ранга, чем подсчет любого ненулевого значения, даже небольшого.

Чтобы проиллюстрировать, как разложение по сингулярным значениям помогает нам исследовать свойства матрицы, мы будем использовать функцию Matlab svd для выполнения разложения по сингулярным значениям и сравнения ее с функцией rref.Рассмотрим следующий пример, в котором матрица Вандермонда создается с помощью функции Matlab vander. Матрица Вандермонда, как известно, плохо обусловлена. СВД позволяет нам изучить природу этого плохого состояния. В частности, ноль или очень маленькое сингулярное значение указывает на недостаток ранга, и этот пример показывает, что особые значения становятся относительно близкими к этому условию. Кроме того, SVD позволяет нам вычислить число обусловленности матрицы. Фактически, функция Cond в Matlab использует SVD для вычисления числа обусловленности, и это дает те же значения, что и полученные путем деления наибольшего сингулярного значения на наименьшее сингулярное значение.Кроме того, евклидова норма матрицы обеспечивается первым сингулярным значением. Сравнивая SVD с процессом RREF в следующем скрипте, мы видим, что результат использования функций Matlab rref и rank дает ранг этой специальной матрицы Вандермонда как 5, но ничего больше нам не сообщает. Нет никаких предупреждений о том, что матрица плохо кондиционирована.

>> c = [1 1,01 1,02 1,03 1,04];

>> V = вандер (c)

V =

1,0000 1,0000 1.0000 1.0000 1.0000

1.0406 1.0303 1.0201 1.0100 1.0000

1.0824 1.0612 1.0404 1.0200 1.0000

1.1255 1.0927 1.0609 1.0300 1.0000

1.1699 1.1249 1.0816 1.0400 1.0000

>> длинный формат

>> s = svd13 (V)

s =

5,210367051037899

0,101918335876689

0,000699698839445

0,000002352380295

0,000000003294983

>> norm (V)

ans =

5.210367051037898

>> конд (В)

ans =

1.581303244929480e + 09

>> s (1) / s (5)

ans =

1.581303244929480e + 09

> > ранг (V)

ans =

5

>> rref (V)

ans =

1 0 0 0 0

0 1 0 0 0

0 0 1 0 0

0 0 0 1 0

0 0 0 0 1

Следующий пример очень похож на предыдущий, но матрица Вандермонда теперь сгенерирована с недостаточным рангом.Наименьшее сингулярное значение, хотя и не ноль, равно нулю для машинной точности, а ранг возвращает значение 4.

>> c = [1 1.01 1.02 1.03 1.03];

>> V = vander (c)

V =

1.0000 1.0000 1.0000 1.0000 1.0000

1.0406 1.0303 1.0201 1.0100 1.0000

1.0824 1.0612 1.0404 1.0200 1.0000

1.1255 1.0927 1.0609 1.0300 1.0000

1.1255 1.0927 1.0927 1.0927 1.0000

>> длинный формат e

>> s = svd (V)

s =

5.187797954424026e + 00

8.336322098941423e-02

3.997349250041025e-04

8.462129966394409e-07

1.261104176071465e-23

>> короткий формат

>> ранг (V) 4

>>

>> rref (V)

ans =

1.0000 0 0 0 -0.9424

0 1.0000 0 0 3.8262

0 0 1.0000 0 -5.8251

0 0 0 1.0000 3.9414

0 0 0 0 0

>> cond (В)

ans =

4.1137e + 23

Функция ранга позволяет пользователю изменять допуск, используя второй параметр, то есть ранг (A, tol), где tol дает допуск для принятия сингулярных значений A как ненулевых. Тем не менее, допуск следует использовать с осторожностью, поскольку функция ранга подсчитывает количество сингулярных значений, превышающих допуск, и это дает ранг матрицы. Если допуск очень мал, то есть меньше точности станка, ранг может быть неправильно подсчитан.

Уменьшение размерности— Связь между SVD и PCA.Т \ ,, $

, где $ v_i $ — это главный компонент $ i $ , или PC, а $ \ lambda_i $ — это $ i $ -е собственное значение $ S $, которое также равно дисперсии данных вдоль $ i $ -й ПК. Это разложение происходит из общей теоремы линейной алгебры, и необходимо проделать некоторую работу , чтобы мотивировать отношение к PCA.

SVD — это общий способ понять матрицу с точки зрения пространства столбцов и строк. (Это способ переписать любую матрицу в терминах других матриц с интуитивно понятным отношением к пространству строк и столбцов. T \ ,, $

, где $ \ {u_i \} $ и $ \ {v_i \} $ — ортонормированные множества векторов.2 = (n-1) \ lambda_i \ ,. $

Это общий факт, что правые сингулярные векторы $ u_i $ охватывают пространство столбцов $ X $. В этом конкретном случае $ u_i $ дает нам масштабированную проекцию данных $ X $ на направление $ i $ -го главного компонента. Левые сингулярные векторы $ v_i $ обычно охватывают пространство строк $ X $, что дает нам набор ортонормированных векторов, охватывающих данные во многом как ПК.

В этой более длинной статье я подробно расскажу о некоторых преимуществах взаимоотношений между PCA и SVD.

Машинное обучение — декомпозиция по сингулярным значениям (SVD) и анализ главных компонентов (PCA) | Джонатан Хуэй

Фото Шелдона НунесаВ машинном обучении (ML) одними из наиболее важных концепций линейной алгебры являются разложение по сингулярным значениям (SVD) и анализ главных компонент (PCA). Как мы можем обнаруживать структуры, собрав все необработанные данные? Например, с учетом процентных ставок за последние 6 дней, можем ли мы понять их состав, чтобы определить тенденции?

Это становится еще сложнее для необработанных данных большой размерности.Это как найти иголку в стоге сена. СВД позволяет извлекать и распутывать информацию. В этой статье мы подробно расскажем о SVD и PCA. Мы предполагаем, что у вас есть базовые знания линейной алгебры, включая ранг и собственные векторы. Если вы испытываете трудности при чтении этой статьи, я предлагаю сначала освежить эти концепции. В конце статьи мы ответим на некоторые вопросы в приведенном выше примере процентной ставки. Эта статья также содержит необязательные разделы. Не стесняйтесь пропустить его в зависимости от вашего уровня интереса.

Я понимаю несколько общих вопросов, которые могут задать не новички. Позвольте мне сначала обратиться к слону в комнате. Есть ли уменьшение габаритов PCA? PCA уменьшает размерность, но это гораздо больше. Мне нравится описание Wiki (но если вы не знаете PCA, это просто бред):

Анализ главных компонентов (PCA) — это статистическая процедура, которая использует ортогональное преобразование для преобразования набора наблюдений возможно коррелированных переменных ( объекты, каждая из которых принимает различные числовые значения) в набор значений линейно некоррелированных переменных, называемых главными компонентами.

С упрощенной точки зрения PCA линейно преобразует данные в новые свойства, которые не коррелируют друг с другом. Что касается машинного обучения, то позиционирование PCA как извлечения признаков может позволить нам лучше изучить его потенциал, чем уменьшение размеров.

В чем разница между СВД и ППШ? SVD дает вам все девять ярдов диагонализации матрицы в специальные матрицы, которыми легко манипулировать и анализировать. Он закладывает основу для разделения данных на независимые компоненты.PCA пропускает менее важные компоненты. Очевидно, мы можем использовать SVD для поиска PCA, усекая менее важные базисные векторы в исходной матрице SVD.

В статье о собственных значениях и собственных векторах мы описываем метод разложения квадратной матрицы n × n A на

Например,

Однако это возможно, только если A, — квадратная матрица и A имеет n линейно независимых собственных векторов. Теперь пришло время разработать решение для всех матриц с использованием SVD.

Матрицы AAᵀ и AᵀA очень специфичны в линейной алгебре. Рассмотрим любую матрицу m × n A , мы можем умножить ее на Aᵀ , чтобы сформировать AAᵀ и AᵀA по отдельности. Эти матрицы:

- симметричные,

- квадратные,

- как минимум положительно полуопределенные (собственные значения равны нулю или положительны),

- обе матрицы имеют одинаковые положительные собственные значения, а

- обе имеют тот же ранг r , что и A .

Кроме того, в этой форме находятся ковариационные матрицы, которые мы часто используем в ML. Поскольку они симметричны, мы можем выбрать их собственные векторы ортонормированными (перпендикулярными друг другу с единичной длиной) — это фундаментальное свойство для симметричных матриц.

Давайте познакомимся с некоторыми терминами, которые часто используются в SVD. Мы называем здесь собственные векторы для AAᵀ как uᵢ и AᵀA как vᵢ и называем эти наборы собственных векторов u и v сингулярными векторами из A.Обе матрицы имеют одинаковые положительные собственные значения. Квадратные корни этих собственных значений называются сингулярными значениями .

Пока не так много объяснений, но давайте сначала соберем все воедино, а потом объяснения. Мы объединяем векторы uᵢ в U и vᵢ в V , чтобы сформировать ортогональные матрицы.

Поскольку эти векторы ортонормированы, легко доказать, что U и V подчиняются

Давайте начнем с трудной части.SVD утверждает, что любая матрица A может быть разложена на множители как:

, где U и V — ортогональные матрицы с ортонормированными собственными векторами, выбранными из AAᵀ и AᵀA соответственно. S — диагональная матрица с r элементами, равными корню из положительных собственных значений AAᵀ или Aᵀ A (обе матрицы в любом случае имеют одинаковые положительные собственные значения).Диагональные элементы состоят из сингулярных значений.

, то есть матрица m × n может быть разложена на множители как:

Мы можем расположить собственные векторы в разном порядке, чтобы получить U и V . Чтобы стандартизировать решение, мы упорядочиваем собственные векторы так, чтобы векторы с более высокими собственными значениями располагались перед векторами с меньшими значениями.

По сравнению с собственным разложением, SVD работает с неквадратными матрицами. U и V обратимы для любой матрицы в SVD, и они ортонормированы, что нам нравится.Без доказательства здесь мы также говорим вам, что особые значения численно более устойчивы, чем собственные значения.

Пример (Источник примера)

Прежде чем заходить слишком далеко, давайте продемонстрируем это на простом примере. Это упростит понимание.

Вычисляем:

Эти матрицы как минимум положительно полуопределенные (все собственные значения положительны или равны нулю). Как показано, они имеют одинаковые положительные собственные значения (25 и 9). На рисунке ниже также показаны соответствующие им собственные векторы.

Сингулярные значения — это квадратный корень из положительных собственных значений, то есть 5 и 3. Следовательно, композиция SVD равна

Чтобы доказать SVD, мы хотим решить U, S, и V с помощью:

У нас есть 3 неизвестных. Надеюсь, мы сможем решить их с помощью трех приведенных выше уравнений. Транспонирование A равно

Зная

Мы вычисляем AᵀA ,

Последнее уравнение эквивалентно определению собственного вектора для матрицы ( AᵀA ) . Мы просто поместили все собственные векторы в матрицу.

с VS² равно

V содержат все собственные векторы vᵢ из AᵀA и S содержат квадратные корни всех собственных значений из AᵀA . Мы можем повторить тот же процесс для AAᵀ и вернуться с аналогичным уравнением.

Теперь мы просто решаем U, V и S относительно

и доказываем теорему.

Ниже приводится краткое изложение СВД.

где

Поскольку матрица V ортогональна, VᵀV равно I . Мы можем переписать уравнение SVD как:

Это уравнение устанавливает важную взаимосвязь между uᵢ и vᵢ .

Отзыв

Применить AV = US ,

Это можно обобщить как

Отзыв,

и

Разложение SVD можно распознать как серию внешних произведений uᵢ и vᵢ.

Эта формулировка SVD является ключом к пониманию компонентов A . Это важный способ разбить массив запутанных данных m × n на – компонентов. Поскольку uᵢ и vᵢ являются единичными векторами, мы даже можем игнорировать члены ( σᵢuᵢvᵢᵀ ) с очень маленьким сингулярным значением σᵢ . (Мы вернемся к этому позже.)

Давайте сначала повторно воспользуемся предыдущим примером и покажем, как он работает.

Матрица A выше может быть разложена как

Далее мы посмотрим, из чего состоят U и V .Скажем, A — это матрица m × n ранга r . AᵀA будет симметричной матрицей размера n × n. Все симметричные матрицы могут выбирать n ортонормированных собственных векторов vⱼ . Поскольку Avᵢ = σᵢuᵢ и vⱼ являются ортонормированными собственными векторами AᵀA, , мы можем вычислить значение uᵢ ᵀ uⱼ как

Оно равно нулю. то есть uᵢ и uⱼ ортогональны друг другу. Как было показано ранее, они также являются собственными векторами AAᵀ.

Из Avᵢ = σuᵢ , мы можем распознать, что uᵢ — вектор-столбец A.

Поскольку A имеет ранг r , мы можем выбрать эти r uᵢ векторы быть ортонормированными. Итак, каковы оставшиеся m — r ортогональные собственные векторы для AAᵀ? Поскольку левое нулевое пространство A ортогонально пространству столбцов, очень естественно выбрать их в качестве оставшегося собственного вектора. (Левый нульsapce N ( Aᵀ) — это промежуток в пространстве x в Aᵀx = 0 .) Аналогичное рассуждение будет работать для собственных векторов для AᵀA. Следовательно,

Чтобы вернуться к прежнему уравнению SVD из

Мы просто возвращаем собственные векторы в левое нулевое пространство и нулевое пространство.

Для системы линейных уравнений мы можем вычислить обратную квадратную матрицу A , чтобы решить x .

Но не все матрицы обратимы. Также в ML вряд ли удастся найти точное решение при наличии шума в данных.Наша цель — найти модель, которая наилучшим образом соответствует данным. Чтобы найти наиболее подходящее решение, мы вычисляем псевдообратную величину

, которая минимизирует приведенную ниже ошибку наименьших квадратов.

И решение для x можно оценить как,

В задаче линейной регрессии x — наша линейная модель, A содержит данные обучения, а b содержит соответствующие метки. Мы можем решить x на

Вот пример.

В машинном обучении мы определяем закономерности и взаимосвязи. Как мы определяем корреляцию свойств в данных? Начнем обсуждение с примера. Мы выбираем рост и вес 12 человек и вычисляем их средние значения. Мы обнуляем исходные значения, вычитая их из среднего значения. Например, Matrix A ниже содержит отрегулированные высоту и вес с нулевым центром.

По мере того, как мы наносим точки данных на график, мы можем признать, что рост и вес положительно связаны. Но как мы можем количественно оценить такие отношения?

Во-первых, как свойство меняется? Вероятно, мы узнаем разницу в средней школе.Представляем его двоюродного брата. Вариант отклонения определяется как:

Примечание. Оно делится на n-1 вместо n в отклонении . При ограниченном размере выборки среднее значение выборки смещено и коррелирует с выборками. Среднее квадратное расстояние от этого среднего будет меньше, чем от общей популяции. Выборочная ковариация S ², деленная на n-1, компенсирует меньшее значение и может оказаться несмещенной оценкой дисперсии σ ².(Доказательство не очень важно, поэтому я просто приведу здесь ссылку на доказательство.)

Дисперсия измеряет, как переменная изменяется между собой, в то время как ковариация находится между двумя переменными ( a и b ).

Мы можем хранить все эти возможные комбинации ковариации в матрице, называемой ковариационной матрицей Σ.

Мы можем переписать это в простой матричной форме.

Диагональные элементы содержат дисперсии отдельных переменных (например, высоты), а недиагональные элементы содержат ковариацию между двумя переменными.Давайте теперь вычислим ковариацию выборки.

Положительная ковариация выборки указывает на положительную корреляцию между весом и ростом. Он будет отрицательным, если они отрицательно коррелированы, и нулевым, если они независимы.

Ковариационная матрица и SVD

Мы можем использовать SVD для разложения выборочной ковариационной матрицы. Поскольку σ₂ относительно мало по сравнению с σ₁ , мы даже можем игнорировать член σ₂ . Когда мы обучаем модель машинного обучения, мы можем выполнить линейную регрессию по весу и росту, чтобы сформировать новое свойство, а не рассматривать их как два отдельных и коррелированных свойства (где запутанные данные обычно усложняют обучение модели).

u₁ имеет одно важное значение. Это главный компонент S .

Существует несколько свойств выборочной ковариационной матрицы в контексте SVD:

- Общая дисперсия данных равна следу выборочной ковариационной матрицы S, которая равна сумме квадратов сингулярных значений S. Имея это, мы можем рассчитать коэффициент потери дисперсии, если мы отбросим меньшие σᵢ членов . Это отражает количество информации, потерянной, если мы удалим их.

- Первый собственный вектор u₁ из S указывает на наиболее важное направление данных. В нашем примере это типичное соотношение веса и роста.

- Ошибка, рассчитанная как сумма квадратов перпендикулярных расстояний от точек выборки до u₁ , является минимальной при использовании SVD.

Свойство

Матрицы ковариации не только симметричны, но и положительно полуопределены.Поскольку дисперсия положительна или равна нулю, uᵀVu ниже всегда больше или равно нулю. По энергетическому тесту В положительно полуопределено.

Следовательно,

Часто после некоторого линейного преобразования A мы хотим узнать ковариацию преобразованных данных. Это можно вычислить с помощью матрицы преобразования A и ковариации исходных данных.

Корреляционная матрица

Корреляционная матрица — это масштабированная версия ковариационной матрицы.Матрица корреляции стандартизирует (масштабирует) переменные, чтобы иметь стандартное отклонение, равное 1.

Матрица корреляции будет использоваться, если переменные имеют масштабы очень разных величин. Плохое масштабирование может повредить алгоритмам машинного обучения, таким как градиентный спуск.

На данный момент у нас есть много уравнений. Давайте визуализируем, что делает SVD, и постепенно развиваем понимание. SVD факторизует матрицу A в USVᵀ. Применение A к вектору x ( Ax ) можно визуализировать как выполнение поворота ( Vᵀ) , масштабирования ( S ) и другого поворота ( U ) на x .

Как показано выше, собственный вектор vᵢ для V преобразуется в:

Или в полной матричной форме

демонстрируют для r = mС uᵢ и vᵢ имеют единичную длину, наиболее доминирующим фактором при определении значимости каждого члена является сингулярное значение σᵢ . Мы намеренно сортируем σᵢ в порядке убывания. Если собственные значения становятся слишком маленькими, мы можем игнорировать оставшиеся члены (+ σᵢuᵢvᵢᵀ +… ).

Эта формулировка имеет некоторые интересные последствия. Например, у нас есть матрица, содержащая доходность акций, которыми торгуют разные инвесторы.

Какую информацию мы можем извлечь из этого, как управляющий фондом? Поиск закономерностей и структур будет первым шагом. Возможно, мы сможем определить комбинацию акций и инвесторов, которые имеют наибольшую доходность. SVD разлагает матрицу размера n × n на r компонентов с сингулярным значением σᵢ , демонстрирующим его значимость.Считайте это способом выделить запутанные и связанные свойства в меньшее количество основных направлений без корреляций.

Если данные сильно коррелированы, следует ожидать, что многие значения σᵢ будут небольшими и их можно будет игнорировать.

В нашем предыдущем примере вес и рост сильно взаимосвязаны. Если у нас есть матрица, содержащая вес и рост 1000 человек, первый компонент в разложении SVD будет доминировать. Вектор u₁ действительно демонстрирует соотношение между весом и ростом среди этих 1000 человек, как мы обсуждали ранее.

Технически SVD извлекает данные соответственно в направлениях с наибольшей дисперсией. PCA — это линейная модель в отображении m -мерных входных объектов на k -мерных скрытых факторов ( k главных компонентов). Если мы игнорируем менее значимые термины, мы удаляем компоненты, которые нам не важны, но сохраняем основные направления с наибольшими отклонениями (наибольшая информация).

Рассмотрим трехмерные точки данных, которые показаны ниже синими точками.Его легко аппроксимировать плоскостью.

ИсточникВы можете быстро понять, что мы можем использовать SVD, чтобы найти матрицу W . Рассмотрим точки данных ниже, которые лежат в двумерном пространстве.

SVD выбирает проекцию, которая максимизирует дисперсию их вывода. Следовательно, PCA выберет синюю линию поверх зеленой, если у нее более высокая дисперсия.

Как указано ниже, мы оставляем собственные векторы, которые имеют верхнее k -е наибольшее сингулярное значение.

Процентная ставка

Давайте проиллюстрируем эту концепцию глубже, проследив приведенный здесь пример с данными о процентных ставках, полученными от Министерства финансов США.Базисные точки для 9 различных процентных ставок (от 3 месяцев, 6 месяцев,… до 20 лет) в течение 6 последовательных рабочих дней собираются с помощью A сохраняет разницу с предыдущей датой. Элементы A также вычтены из среднего значения уже за этот период. то есть с нулевым центром (по его строке).

Выборочная матрица ковариаций равна S = AAᵀ / (5–1) .

Теперь у нас есть ковариационная матрица S , которую мы хотим факторизовать.Разложение SVD — это

Из разложения SVD мы понимаем, что можем сосредоточиться на первых трех основных компонентах.

Как показано, первый главный компонент связан со средневзвешенным дневным изменением для всех сроков погашения. Второй главный компонент корректирует дневное изменение, чувствительное к сроку погашения облигации. (Третий главный компонент — это, вероятно, кривизна — производная второй степени.)

Мы хорошо понимаем взаимосвязь между интересным изменением ставки и зрелостью в нашей повседневной жизни.Таким образом, основные компоненты подтверждают наши представления о поведении процентных ставок. Но когда нам представляются незнакомые необработанные данные, PCA очень полезен для извлечения основных компонентов ваших данных, чтобы найти нижележащую информационную структуру. Это может ответить на некоторые вопросы о том, как найти иголку в стоге сена.

Масштабировать элементы перед выполнением СВД.

Скажем, мы хотим сохранить 99% дисперсии, мы можем выбрать k так, чтобы

Разложение по сингулярным значениям как можно проще

За гранью определения

По моему опыту, разложение по сингулярным числам (SVD) обычно представляется следующим образом: любая матрица $ M \ in \ mathbb {C} ^ {m \ times n} $ может быть разложена на три матрицы,

, где $ U $ — унитарная матрица $ m \ times m $, $ \ Sigma $ — диагональная матрица $ m \ times n $, а $ V $ — унитарная матрица $ n \ times n $.{*} $ — сопряженное транспонирование $ V $. В зависимости от источника, автор может взять несколько предложений, чтобы прокомментировать, как это уравнение можно рассматривать как разложение линейного преобразования $ M $ на два преобразования вращения и одно преобразование растяжения или что мотивирующий геометрический факт заключается в том, что изображение единицы сфера под любой матрицей $ m \ times n $ является гиперэллипсом. Но как мы пришли к этому уравнению и как эти геометрические интуиции соотносятся с уравнением выше?

Цель этой публикации проста: я хочу объяснить SVD за пределами этого определения.Вместо того, чтобы представлять уравнение \ ref {eq1} в его окончательной форме, я хочу развить его, исходя из первых принципов. Я начну с объяснения SVD без жаргона, а затем формализую объяснение, чтобы дать определение в уравнении \ ref {eq1}. Наконец, я расскажу о применении SVD, которое продемонстрирует его полезность. В будущих публикациях я надеюсь доказать существование и уникальность СВД и подробно объяснить рандомизированную СВД.

Этот пост будет во многом полагаться на геометрическое понимание матриц.Если вы не знакомы с этой концепцией, прочтите мой предыдущий пост по этой теме.

СВД без жаргона

Жаргон полезен при разговоре с сообществом экспертов, но я считаю, что, по крайней мере, для себя, легко использовать жаргон, чтобы замаскировать, когда я чего-то не понимаю. Если бы я представил SVD математику, сила жаргона заключалась бы в том, что я мог бы быстро и точно передать ключевые идеи. Обратной стороной является то, что я мог просто использовать слова без полного понимания основной идеи, в то время как мой опытный слушатель заполнял пробелы.В качестве упражнения я хочу сначала представить SVD без жаргона, как если бы объяснял его заинтересованному 14-летнему подростку — подумайте о математической зрелости восьмого класса. Затем я формализую это интуитивное объяснение, чтобы работать над стандартной формулировкой. Итак, поехали.

Представьте, что у нас есть квадрат. Квадрат, как и ваша рука, образующая букву «L», имеет особую ориентацию, которую мы графически изображаем стрелками (рис. $ 1 $).

Рисунок 1: Квадрат со стрелками направления.

Мы можем управлять этим квадратом определенными способами. Например, мы можем потянуть или надавить на край, чтобы растянуть или сжать квадрат (рис. 2A и 2B). Мы можем повернуть квадрат (рис. 2C) или перевернуть его, чтобы изменить его ориентацию — представьте, что вы перевернули руку так, чтобы буква «L» превратилась в «⅃» (рисунок 2D). Мы можем даже срезать квадрат, то есть деформировать его, прикладывая силу вверх, вниз, влево или вправо к одному из углов квадрата (рис. 2E).

Рисунок 2: Наш исходный квадрат при различных типах преобразований: (A) растянутый, (B) сжатый, (C) повернутый, (D) отраженный или перевернутый и (E) сдвинутый.

Единственное ограничение состоит в том, что наше преобразование должно быть линейным . Интуитивно линейное преобразование — это преобразование, при котором прямая линия до преобразования приводит к прямой линии после преобразования. Чтобы представить себе, что это означает, представьте сетку из равномерно расположенных вертикальных и горизонтальных линий на нашем квадрате. Теперь давайте проведем диагональную линию на квадрате и произведем некоторые преобразования. Линейное преобразование будет таким, чтобы после преобразования эта диагональная линия оставалась прямой (рис. 3B).{\ prime} $ (C).

Хорошо, теперь, когда мы определили наш квадрат и то, что мы можем с ним сделать, мы можем сказать следующее, что является классным математическим фактом: любое преобразование $ M $ в этот квадрат, при условии, что наше преобразование является линейным, может быть рассмотрено как простое растяжение, сжатие или переворачивание квадрата — другими словами, без сдвига — , если , мы должным образом повернем квадрат перед выполнением преобразования.

Давайте представим это на примере. Представьте, что мы разделили наш квадрат, надавив горизонтально на его верхний левый угол (рис. 4A).В результате получается стриженый квадрат, похожий на перевернутый старый сарай. Но если бы мы повернули наш квадрат перед тем, как толкнуть его в сторону, сдвиг приведет только к растяжению и сжатию квадрата, хотя и в новой ориентации (рис. 4B).

Рисунок 4: Геометрическая сущность SVD: любое линейное преобразование $ M $ нашего квадрата (A) можно рассматривать как простое растяжение, сжатие или отражение этого квадрата, при условии, что мы сначала повернем квадрат (B).

Это геометрическая сущность СВД. Любое линейное преобразование можно рассматривать как простое растяжение, сжатие или переворачивание квадрата при условии, что нам разрешено сначала повернуть его. Преобразованный квадрат или прямоугольник может иметь новую ориентацию после преобразования.

Почему это полезно? Сингулярные значения , упоминаемые в названии «разложение по сингулярным значениям», представляют собой просто длину и ширину преобразованного квадрата, и эти значения могут рассказать вам о многом. Например, если одно из сингулярных значений равно $ 0 $, это означает, что наше преобразование сглаживает наш квадрат.И большее из двух сингулярных значений говорит вам о максимальном «действии» преобразования.

Если это второе утверждение не имеет смысла, рассмотрите возможность визуализации нашего преобразования без второго поворота, который никак не влияет на размер прямоугольника. Кроме того, вместо того, чтобы растягивать (или сглаживать) квадрат в прямоугольник, представьте, что вы растягиваете круг в эллипс (мы поймем, почему через секунду) (рис. 5).

Рисунок 5: (A) Ориентированный круг; Если это поможет, представьте себе этот круг, вписанный в наш исходный квадрат.(B) Наш круг превратился в эллипс. Длина большой и малой осей эллипса имеет значения $ \ sigma_1 $ и $ \ sigma_2 $ соответственно, называемые сингулярными значениями .

Что представляет собой фигура 5 в геометрическом плане? Большее из двух сингулярных значений — это длина большой оси эллипса. И поскольку мы преобразовали идеальный круг, все возможные радиусы (край круга) были растянуты до края нового эллипса. Какой из этих радиусов одинакового размера был растянут больше всего? Тот, который тянул по большой оси.Таким образом, радиус, который был растянут больше всего, был растянут на величину, точно равную наибольшему сингулярному значению.

От интуиции к определению

Теперь, когда у нас есть геометрическая интуиция для SVD, давайте формализуем эти идеи. Здесь я предполагаю, что читатель знаком с базовой линейной алгеброй. Мы хотим снова использовать жаргон, чтобы говорить точно и эффективно.

Во-первых, давайте назовем вещи. Напомним, что любая пара ортогональных векторов в двумерном пространстве образует основу этого пространства.В нашем случае назовем ортогональные векторы во входном пространстве $ \ textbf {v} _1 $ и $ \ textbf {v} _2 $ (рисунок 6A). После применения матричного преобразования $ M $ к этим двум векторам мы получаем $ M \ textbf {v} _1 $ и $ M \ textbf {v} _2 $ (рисунок 6B). Кроме того, давайте разложим эти два преобразованных вектора на единичные векторы $ \ textbf {u} _1 $ и $ \ textbf {u} _2 $, умноженные на их соответствующие величины, $ \ sigma_1 $ и $ \ sigma_2 $. Другими словами:

Пока мы ничего нового не сказали. Мы просто называем вещи.

Рисунок 6: Формализация геометрической сущности SVD: если мы правильно повернем нашу область, определяемую базисными векторами $ \ textbf {v} _1 $ и $ \ textbf {v} _2 $, то любое линейное преобразование $ M $ будет просто преобразованием диагональной матрицей (расширяющейся, отражающей) в потенциально повернутом диапазоне, определяемом $ \ textbf {u} _1 $ и $ \ textbf {u} _2 $.

Но теперь, когда у нас есть имена, мы можем провести небольшую алгебраическую манипуляцию. Во-первых, обратите внимание, что любой вектор $ \ textbf {x} $ можно описать с помощью базисных векторов $ \ textbf {v} _1 $ и $ \ textbf {v} _2 $ следующим образом:

, где $ \ textbf {a} \ cdot \ textbf {b} $ обозначает скалярное произведение между векторами $ \ textbf {a} $ и $ \ textbf {b} $.Если вы не уверены в приведенной выше формулировке, рассмотрите аналогичную формулировку со стандартными базисными векторами:

, где $ x_i $ обозначает $ i $ -й компонент $ \ textbf {x} $. В уравнении \ ref {eq3} мы проецируем с помощью скалярного произведения $ \ textbf {x} $ на $ \ textbf {v} _1 $ и $ \ textbf {v} _2 $ перед разложением членов с использованием базиса векторы $ \ textbf {v} _1 $ и $ \ textbf {v} _2 $.

Затем давайте умножим слева обе части уравнения \ ref {eq3} на наше матричное преобразование $ M $. Поскольку скалярное произведение дает скаляр, мы можем распределить и переместить $ M $ следующим образом:

Затем мы можем переписать $ M \ textbf {v} _i $ как $ \ textbf {u} _i \ sigma_i $:

Мы почти у цели.{\ top} \ textbf {x} $. И поскольку каждый член скалярного произведения является скаляром, мы перемещаем каждый из них в конец соответствующих выражений:

Теперь мы можем удалить $ \ textbf {x} $ из обеих частей уравнения, потому что, как правило, $ A \ mathbf {x} = B \ mathbf {x} \ подразумевает A = B $. Подробнее см. Обсуждение здесь. Было бы проще интуитивно понять, если мы переписываем утверждение как $ (A — B) \ mathbf {x} = 0 \ implies A — B = 0 $. Удаляя $ \ mathbf {x} $, получаем:

Учитывая правильно определенные матрицы, уравнение \ ref {eq4} становится SVD в его канонической форме (Equation \ ref {eq1}) для матриц $ 2 \ times 2 $:

Кроме того, вы должны иметь интуитивное представление о том, что это означает.Любое матричное преобразование может быть представлено как диагональное преобразование (расширение, отражение), определяемое $ \ Sigma $, при условии, что сначала правильно повернуты область и диапазон.

Векторы $ \ textbf {u} _i $ называются левыми сингулярными векторами, а векторы $ \ textbf {v} _i $ называются правыми сингулярными векторами. Эта ориентировочная терминология немного сбивает с толку, потому что «левый» и «правый» происходят из приведенного выше уравнения, в то время как на наших диаграммах прямоугольников и эллипсов векторы $ \ textbf {v} _i $ находятся слева.

Стандартная рецептура

Теперь, когда у нас есть простая геометрическая интуиция для SVD и мы формализовали ее для всех матриц $ 2 \ times 2 $, давайте переформулируем задачу в общем и стандартным способом. Если переход от $ 2 $ -мерного к $ n $ -мерному измерению является сложной задачей, вспомните совет Джеффа Хинтона:

Чтобы иметь дело с гиперплоскостями в 14-мерном пространстве, визуализируйте трехмерное пространство и очень громко скажите себе «четырнадцать». Все так делают.

Учтите, что, учитывая наши определения $ \ textbf {v} _i $, $ \ textbf {u} _i $ и $ \ sigma_i $, мы можем переписать уравнение \ ref {eq2} для произвольной матрицы $ m \ times n $ $ M $ как:

, что сразу же дает нам уравнение \ ref {eq5} снова, но для матриц $ m \ times n $:

Здесь $ U $ унитарна и $ m \ times m $; $ V $ унитарен и $ n \ times n $; а $ \ Sigma $ диагональна и $ m \ times n $.{\ top} $ — ортонормированные правые сингулярные векторы. Пунктирные области — отступы.

Диагональные элементы $ \ Sigma $ являются сингулярными числами. Не умаляя общности, мы можем предположить, что особые значения упорядочены — для их упорядочения может потребоваться переупорядочение столбцов в $ U $ и $ V $. И их геометрическая интерпретация верна в более высоких измерениях. Например, если мы выполнили SVD на матрице $ m \ times n $ и заметили, что нижние сингулярные значения $ k $ были меньше, чем некоторый эпсилон, вы могли бы визуализировать это преобразование матрицы как выравнивание гиперэллипса по этим $ k $ измерениям.Или, если у вас есть экспоненциальный спад значения сингулярных значений, это предполагает, что все «действие» матрицы происходит только в нескольких измерениях.

И все! Это СВД. Вы можете прочитать о различиях между полным и усеченным SVD, об обработке матриц низкого ранга и т. Д. В лучших ресурсах, чем этот. Моей целью было прийти к уравнению \ ref {eq1} с помощью как можно более простых рассуждений. По крайней мере, на мой взгляд, медленное рассмотрение геометрической интуиции делает объяснения SVD более понятными.

Повторная визуализация SVD

Теперь, когда мы понимаем SVD, мы можем убедить себя, что то, как мы визуализировали его, верное. Рассмотрим рисунок 8, который был создан с использованием Matplotlib и реализации SVD в NumPy, np.linalg.svd . Мы видим, что эти цифры в точности совпадают с нашей интуицией относительно того, что происходит с SVD в $ 2 $ -мерном измерении.

Рисунок 8: Несколько примеров использования реализации SVD в NumPy для визуализации алгоритма.{*} $ перед применением преобразования. Каждая пунктирная линия — это верхний сингулярный вектор соответствующего преобразования.

Приложения

SVD относится ко многим другим свойствам матрицы. Количество ненулевых сингулярных значений равно рангу матрицы. Вот почему спектральная норма является выпуклым суррогатом для приближений низкого ранга. Диапазон матрицы — это пространство, охватываемое векторами $ \ {\ textbf {u} _1, \ textbf {u} _2, \ dots, \ textbf {u} _r \} $, где $ r $ — количество ненулевых сингулярные значения и все сингулярные значения и векторы упорядочены.Матрица необратима, если ее сингулярное значение равно нулю, потому что преобразование «схлопывает» $ n $ -куб по крайней мере по одному измерению. И так далее. Как только SVD понят, я думаю, довольно просто интуитивно понять , почему должны выполняться вышеупомянутые свойства. См. Подробности в главе 5 (Trefethen & Bau III, 1997).

Один алгоритм, который мне намного легче понять после понимания SVD, — это анализ главных компонентов (PCA). Вместо того, чтобы предполагать, что вы знаете, как работает PCA, давайте посмотрим, что вычисляет PCA, а затем давайте рассмотрим, что делает PCA с нашими знаниями SVD.{\ top} U = I $. И даже не зная о собственных векторах или собственных значениях, мы можем увидеть, что делает PCA, понимая SVD: это диагонализация ковариационной матрицы $ X $ . Таким образом, PCA находит основные оси, по которым меняются наши данные.

Если неясно, что означает SVD или собственное разложение данных, у Джереми Кун есть хорошая запись в блоге об этом.

Заключение

Разложение по сингулярным числам или SVD — мощный инструмент линейной алгебры. Понимание того, что представляет собой разложение геометрически, полезно для интуитивного понимания других свойств матрицы, а также помогает нам лучше понимать алгоритмы, основанные на SVD.